株式会社サイバーエージェント(本社:東京都渋谷区、代表取締役社長:藤田晋、東証一部上場:証券コード4751)は、人工知能技術の研究開発組織「AI Lab」に所属する研究員の加藤真大*・安井翔太、コーネル大学の上原雅俊氏*らによる共著論文が、機械学習分野の国際会議「NeurIPS 2020」(※1)のSpotlightにて採択されたことをお知らせいたします。(*共同主著)

「NeurIPS」は世界中の研究者によって毎年開催される国際会議で、「ICML」「KDD」(※2)などと並び、機械学習の分野で権威あるトップカンファレンスの一つです。Spotlightは採択された論文の中でも限られた研究のみに与えられ、2020年では採択率3%程度と非常に難易度の高いものです。この度「AI Lab」から採択された論文は、2020年12月にオンラインで開催される「NeurIPS 2020」で発表を行います。

■研究背景

「AI Lab」ではマーケティング全般に関わる幅広いAI技術を研究開発しており、大学・学術機関との産学連携を強化しながら様々な技術課題に取組むとともに、産学連携によって培ってきた技術を当社のビジネス課題と結びつけるような、より実践的な研究開発を行ってまいりました。

近年様々なウェブサービスにおいて、機械学習を用いた意思決定がサービスの質を左右する重要な役割を果たしており、例えばインターネット広告においては、ユーザーの属性や広告枠の特徴に対して最適な広告画像を選択するという意思決定がユーザーのアクセスごとに行われています。

このような状況において、機械学習を利用した意思決定モデルを使用するためには、データを用いて意志決定の質を評価するとともに、その評価を最大にするようにモデルを学習する必要があります。しかし、実際に入手可能なデータにおいては過去に行われた選択の結果しか観測されず、仮に他の選択を行った場合に何が起きていたのかという反実仮想の結果は観測されていません。その為、新たな意思決定モデルが過去の選択とは異なる選択を行った場合には、データを用いた評価が難しいという問題点があります。

このような課題から、近年、評価と学習を行う「Off-Policy Evaluation/Learning」と呼ばれる分野が注目を集めています。

当社ではこの領域に対して「CFML(Counterfactual Machine Learning)勉強会」を定期的に行うほか、共著論文「Efficient Counterfactual Learning from Bandit Feedback」(※3)を執筆し「AAAI」に論文採択されるなど、積極的な学術貢献を行ってまいりました。

■論文研究の概要

このような背景のもと、今回採択された共著論文「Off-Policy Evaluation and Learning for External Validity under a Covariate Shift」(※4)では、外的妥当性を考慮した意思決定の事前評価手法を開発し提案しました。

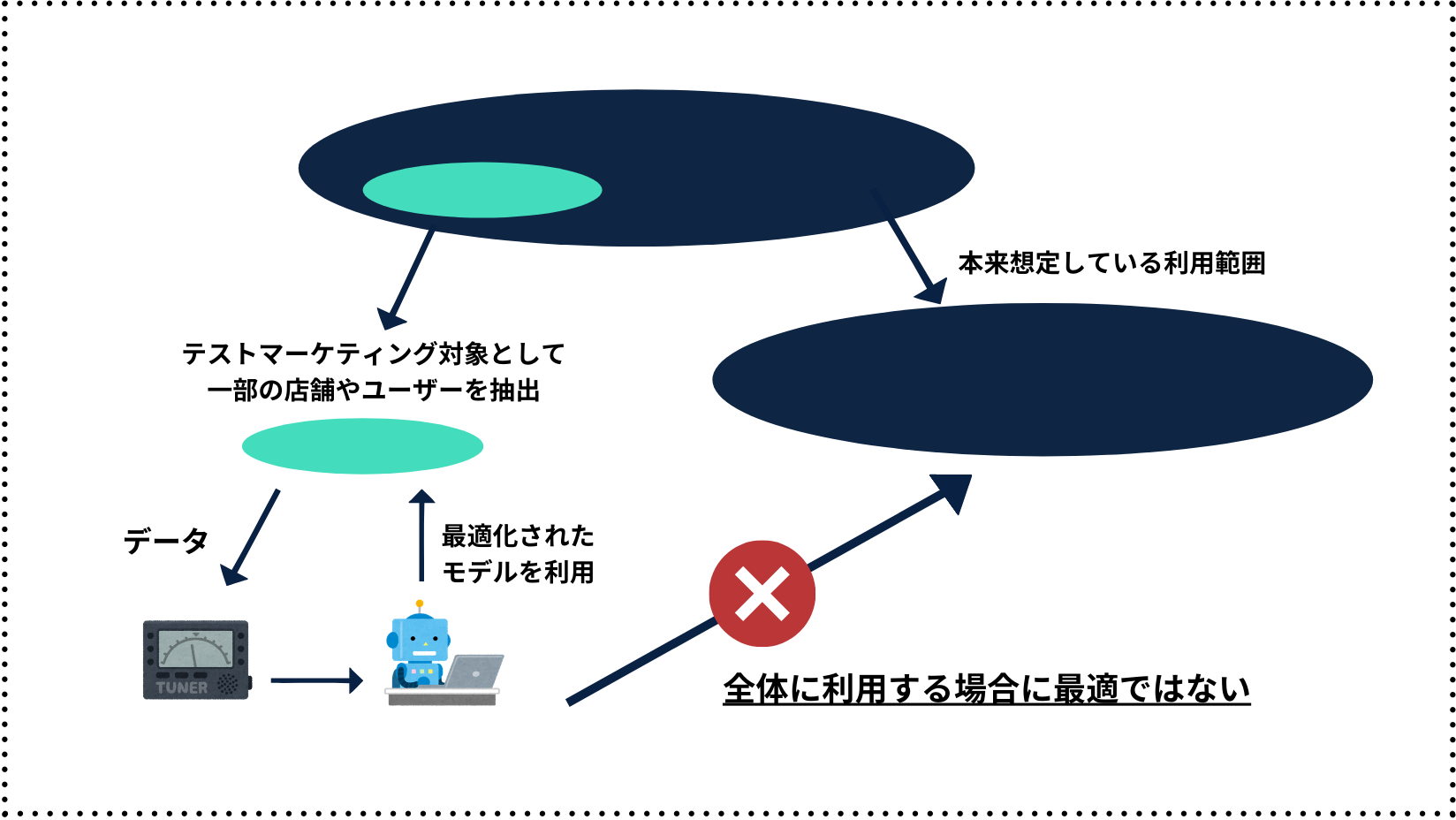

実際のビジネスでは、新たな環境に意思決定モデルを導入するケースが多く存在します。例えば意思決定モデルを新たにサービスへと導入する際には、テストマーケティングとして限定された地域・店舗・ユーザーに導入し、評価を行ったのちに全体へと導入されます。このように一部の限られた環境から大きく適応範囲を広げる際、その環境の違いから限られた環境での評価があてはまらないといった、外的妥当性の問題が発生します。

▼「外的妥当性の問題」イメージ図

「NeurIPS」は世界中の研究者によって毎年開催される国際会議で、「ICML」「KDD」(※2)などと並び、機械学習の分野で権威あるトップカンファレンスの一つです。Spotlightは採択された論文の中でも限られた研究のみに与えられ、2020年では採択率3%程度と非常に難易度の高いものです。この度「AI Lab」から採択された論文は、2020年12月にオンラインで開催される「NeurIPS 2020」で発表を行います。

■研究背景

「AI Lab」ではマーケティング全般に関わる幅広いAI技術を研究開発しており、大学・学術機関との産学連携を強化しながら様々な技術課題に取組むとともに、産学連携によって培ってきた技術を当社のビジネス課題と結びつけるような、より実践的な研究開発を行ってまいりました。

近年様々なウェブサービスにおいて、機械学習を用いた意思決定がサービスの質を左右する重要な役割を果たしており、例えばインターネット広告においては、ユーザーの属性や広告枠の特徴に対して最適な広告画像を選択するという意思決定がユーザーのアクセスごとに行われています。

このような状況において、機械学習を利用した意思決定モデルを使用するためには、データを用いて意志決定の質を評価するとともに、その評価を最大にするようにモデルを学習する必要があります。しかし、実際に入手可能なデータにおいては過去に行われた選択の結果しか観測されず、仮に他の選択を行った場合に何が起きていたのかという反実仮想の結果は観測されていません。その為、新たな意思決定モデルが過去の選択とは異なる選択を行った場合には、データを用いた評価が難しいという問題点があります。

このような課題から、近年、評価と学習を行う「Off-Policy Evaluation/Learning」と呼ばれる分野が注目を集めています。

当社ではこの領域に対して「CFML(Counterfactual Machine Learning)勉強会」を定期的に行うほか、共著論文「Efficient Counterfactual Learning from Bandit Feedback」(※3)を執筆し「AAAI」に論文採択されるなど、積極的な学術貢献を行ってまいりました。

■論文研究の概要

このような背景のもと、今回採択された共著論文「Off-Policy Evaluation and Learning for External Validity under a Covariate Shift」(※4)では、外的妥当性を考慮した意思決定の事前評価手法を開発し提案しました。

実際のビジネスでは、新たな環境に意思決定モデルを導入するケースが多く存在します。例えば意思決定モデルを新たにサービスへと導入する際には、テストマーケティングとして限定された地域・店舗・ユーザーに導入し、評価を行ったのちに全体へと導入されます。このように一部の限られた環境から大きく適応範囲を広げる際、その環境の違いから限られた環境での評価があてはまらないといった、外的妥当性の問題が発生します。

▼「外的妥当性の問題」イメージ図

本研究では、「テスト環境」と「新たに適応したい環境」の関係性をデータを用いて評価し、その評価結果を応用することで、「テスト環境におけるデータ」を用いて外的妥当性の問題を考慮した意思決定モデルの事前評価と学習を可能にしました。これにより、テストマーケティングのような限られた機会を最大限利用した上で、顧客にとってより価値のある意思決定モデルを提供することが可能になります。

■今後

今回の提案は、当社で提供している広告配信プロダクトや、リリースを予定している多くのDXプロダクトに導入を予定しており、企業のブランディングや購買率の増加などを目的とした様々なマーケティング活動において貢献が期待されます。「AI Lab」は今後もAI技術を用いた広告配信技術をプロダクトに取り入れるべく、より品質の高い広告配信技術の実現を目指し、研究・開発に努めてまいります。

※1「NeurIPS」 Neural Information Processing Systems

※2「ICML」International Conference on Machine Learning

「KDD」International Conference on Knowledge Discovery and Data Mining

※3 Narita, Yusuke, Yasui Shota and Yata Kohei. "Efficient Counterfactual Learning from Bandit Feedback." AAAI. 2019

※4 Masahiro Kato, Masatoshi Uehara, and Shota Yasui. "Off-Policy Evaluation and Learning for External Validity under a Covariate Shift." NeurIPS. 2020.

■今後

今回の提案は、当社で提供している広告配信プロダクトや、リリースを予定している多くのDXプロダクトに導入を予定しており、企業のブランディングや購買率の増加などを目的とした様々なマーケティング活動において貢献が期待されます。「AI Lab」は今後もAI技術を用いた広告配信技術をプロダクトに取り入れるべく、より品質の高い広告配信技術の実現を目指し、研究・開発に努めてまいります。

※1「NeurIPS」 Neural Information Processing Systems

※2「ICML」International Conference on Machine Learning

「KDD」International Conference on Knowledge Discovery and Data Mining

※3 Narita, Yusuke, Yasui Shota and Yata Kohei. "Efficient Counterfactual Learning from Bandit Feedback." AAAI. 2019

※4 Masahiro Kato, Masatoshi Uehara, and Shota Yasui. "Off-Policy Evaluation and Learning for External Validity under a Covariate Shift." NeurIPS. 2020.