AR分野のNextExpertsが描く、バーチャルスタジオと空間コンピューティングのビジネス実装

当社には、特定の分野に抜きん出た知識とスキルを持ち、第一人者として実績を上げているエンジニアを選出する「Developer Experts制度」があります。その次世代版である「Next Experts」として選出したエンジニアは、各専門領域において培った知見をサイバーエージェントグループ全体に還元すべく、技術力の向上に努めています。

AR分野のNext Expertsである服部は、バーチャルスタジオ収録における撮影ワークフローの構築や改善や、「visionOS」と「Apple Vision Pro」を活用した空間コンピューティングによる新しい表現を模索しています。そんな服部に「AR分野のNextExperts」として新しいテクノロジーに向き合う姿勢や考え方を聞いてみました。

Profile

-

服部 智 (株式会社Cyber AI Productions)

2017年サイバーエージェント入社。(株)AbemaTVでiOS、Nintendo Switchなどのアプリ開発に携わった後、2021年よりAI/CG部門に異動しVirtual Production系開発に従事。AR的な実装と表現が好き。iOSDC、try! Swift、XR Kaigi、AWE USA、Let's visionOSなど登壇多数。

バーチャルスタジオにおけるスタジオテックと、AR分野のNextExperts

── 服部さんの、現在のお仕事や役割について教えて下さい。

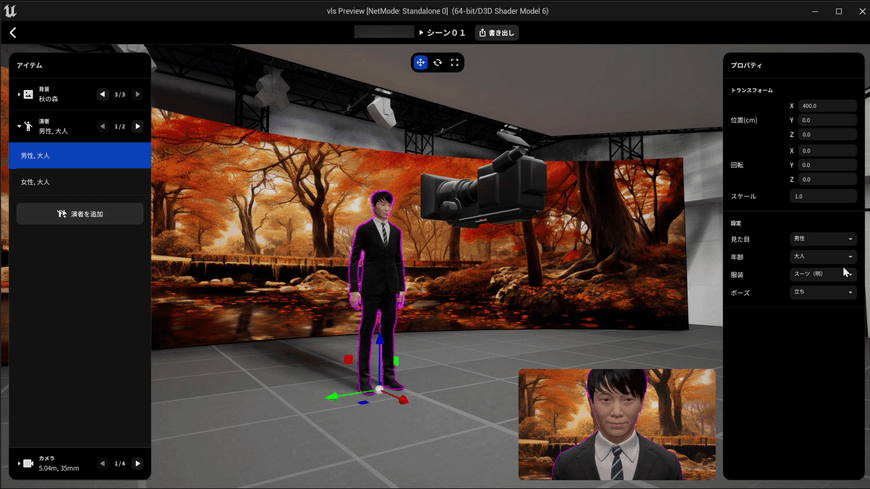

私は現在、(株)Cyber AI ProductionsのVirtual Forceチームに所属するXRエンジニアです。「極(きわみ)AIお台場スタジオ」でのバーチャルスタジオ収録における、撮影ワークフローの構築や改善を担当しています。「Unreal Engine」を活用したバーチャルスタジオ撮影シミュレーションツール「Virtual LED Studio」の開発や、撮影の課題を解決するツールの開発を手掛けています。

並行して、サイバーエージェントのDeveloper Experts制度における、AR分野のNextExpertsを担っています。CAゼミ制度の「xRギルド」という開発コミュニティのオーナーとして、AR/VR/MRの技術知見を社内に共有しながら、自社サービスへの導入を目標としたプロトタイプ開発をしています。過去には、メンバーと共同で競輪ARアプリを開発しました。このアプリは現在も技術的なアップデートや新機能の実装が行われ「ミッドナイト競輪」の番組内で積極的に活用されています。

AR分野のNextExpertsとして、現在はApple社の「visionOS」の第一人者となるべく、技術検証やプロダクト導入の可能性を模索しています。2024年5月にはtry! Swift Tokyo 2024に登壇し「SwiftでvisionOSのアプリをつくろう」というテーマで発表しました。また、2024年8月には共著で執筆した技術書『Apple Vision Proアプリ開発ガイド~visionOSではじめる空間コンピューティング実践集』が技術評論社から発売されます。

「visionOS」とApple Vision Proの登場により、空間コンピューティング(Spatial Compuing)という新たなパラダイムシフトが訪れようとしています。今後ヘッドセット型端末での空間コンピューティング体験が数多く提供されていくと思われます。

サイバーエージェントにおいても、AR分野のビジネスニーズはさらに広がると考えられます。AI事業本部やCyber AI Productionsでも、実証実験を兼ねた企業コラボが始まっています。

バーチャルスタジオを仮想化。撮影現場のシミュレーション化で制作ワークフローを圧縮する

── 「極(きわみ)AIお台場スタジオ」におけるスタジオテックエンジニアのお仕事について教えて下さい

インターネット広告で効果を高めるには、視聴者の好みやトレンドに応じて、広告クリエイティブを柔軟に変えることが重要です。それを実現するのが「極(きわみ)AIお台場スタジオ」です。

このクリエイティブ制作スタジオは「AI × バーチャルスタジオで、広告の常識を変える」をコンセプトに設計されています。スタジオには、幅15メートルのシリンドリカル型LEDウォール、3面構成のxRスタジオ、0.84mmピッチの高精細かつ可動式LEDウォール、4Dスキャンシステム、専用サーバー室、xRや音声合成用のスタジオなど、国内最大規模の設備が揃っています。

巨大LEDウォールを活用し、季節や天候、さらに北海道や沖縄、ハワイなど各地でロケしたかのような背景シーンを演出できます。巨大LEDウォールや様々な照明機材、モーションコントロールカメラを使用することで、その場にいるようなリアルな背景を作り出し、演者が演技に没頭できる空間を提供します。

そんな「極(きわみ)AIお台場スタジオ」のセットや撮影環境を、Unreal Engine上に構築し、シミュレーション可能とする事で、バーチャルスタジオでの撮影を効率化するツールが、我々が開発している「Virtual LED Studio」です。

「Virtual LED Studio」の特徴として、LEDウォールの投影、カメラワーク、ライティングなどの撮影環境を3DCG上でシミュレーションし、準備から当日の撮影ワークフローを効率化する機能が備わっています。

── 「極(きわみ)AIお台場スタジオ」のセットそのものがUnreal Engineの仮想空間で再現されているという事ですか。どういった課題が背景になって開発したのですか?

LEDウォールを活用したバーチャルプロダクションスタジオは、多数の機材やソフトウェアを複合的に組み合わせて制作します。例えば、カメラ機材の位置を測定し、そのトラッキング情報をもとにゲームエンジン側でカメラの画角やレンズを再現するなどです。この技術はIn-Camera VFXと呼ばれ、LED画面に適切な表示処理を行うことで、カメラ機材を通して見ると立体的に見える仕組みを実現しています。つまり、LEDウォール、トラッキング、カメラ、リアルタイム3DCGが組み合わさることで、立体感のあるリアルな撮影が可能になります。

その過程で例えば、美術(家具や植物など現実の小道具)を配置することで、よりリアルなバーチャルプロダクションの撮影が可能になったりもします。美術だけでなく、アングル、照明、演者の立ち位置や動線など、一連の撮影ワークフローをある程度決めることで、クオリティーが格段に向上します。

LEDウォールを活用したバーチャルプロダクションスタジオは、現地ロケと比較すると、遥かに少人数かつ短期間での収録が可能です。しかし、バーチャルプロダクションスタジオ特有の課題も存在します。例えば、ステージの大幅な変更や撮影当日に追加のクリエイティブ素材が必要になる場合には、対応コストが発生します。また、LEDウォールを使った撮影では、カメラアングルが想定からズレると、パースが合わず違和感が生じることもあります。

特に、LEDウォールと連携したバーチャルプロダクションスタジオ用のデジタルシネマカメラは、ゲームエンジン側とのキャリブレーションが必要です。セットや立ち位置を変えるだけでも、キャリブレーションに調整が入るので、演者やスタッフの待機時間が発生する可能性があります。

そこで開発されたのが「Virtual LED Studio」です。Unreal Engine上で撮影のワークフローをシミュレーションすることで、当日の収録効率を向上させる事が可能になります。Virtual LED Studioでは「極(きわみ)AIお台場スタジオ」における照明位置からカメラ画角の確認まで行えます。Unreal Engineのバーチャルカメラには、リアルのカメラと同様のレンズ設定があるため、当日の撮影と同じ状況を再現する事ができるので、カメラマンを交えたカメラアングルの事前チェックが可能となります。

Unreal Engine上に実際のスタジオと同じ間取りの3Dモデルを実現していますので、事前にライトの位置や演者の動線、美術の配置などをシミュレーションできます。これにより、ロケハンの短縮や、セットの組み直しや撮り直し、台本の修正を防ぐことが可能です。

── 「Virtual LED Studio」はバーチャルプロダクションスタジオ撮影においてどんな効果をもたらしていますか?

動画広告のニーズが高まる中、スピーディーかつ多様なバリエーションの素材を収録できるバーチャルプロダクションスタジオ撮影は、ビジネス的にもニーズがあります。Cyber AI Productionsでも多数の案件実績がありますし「極(きわみ)AIお台場スタジオ」には毎月たくさんの企業が見学に来られています。

そんな中「Virtual LED Studio」の活用により、LEDウォールやカメラなどの物理的な機材を使った準備やロケハンに、スタジオを1日占有してしまうところを、仮想空間上でロケハンや準備の一部を担えるようになりました。

このように「Virtual LED Studio」の活用で、撮影現場の少人数化やスケジュールの短縮化、コスト削減に役立っています。

今後は、現実世界と融合したARやMR、空間コンピューティングの活用も模索しています。特に「visionOS」が提供する空間コンピューティングは、バーチャルスタジオと親和性が高いので「Apple Vision Pro」でのシミュレーション機能を実装することも考えています。例えば、関係者がそれぞれ「Apple Vision Pro」を装着して、スタジオエリアのセットを確認しながら、現場の技術者とリモートの演出担当で議論する等も可能となるかもしれません。

「visionOS」と空間コンピューティングがもたらすパラダイムシフト

── Apple Vision Proの米国外での発売もあり、世界中で空間コンピューティングが注目されていますね。

私は、カルフォルニア州にあるApple Parkで開催された「WWDC2023」における「AppleVisionPro」の発表に現地で立ち会いました。その場にいた観衆と共に、新しいテクノロジーへの熱狂と、未来への興奮を肌で感じた者の一人です。

今後、Apple Vision Proをはじめとして様々な機器が登場し、新たな空間コンピューティングの世界が広がっていく事が予想されます。

2024年6月28日に「ABEMA」がApple Vision Proでコンテンツ視聴を可能にする発表をしているように「visionOS」と「Apple Vision Pro」がもたらす空間コンピューティングは、サイバーエージェントの既存事業と非常に親和性が高いと思います。私が個人的にイメージするだけでも、ゲーム事業やプロレス事業、興行事業などにおいて相性が良いと感じます。

── Appleが公開している「visionOS SDK」で確認できる技術の中で、特にどんな技術に注目していますか?

空間オーディオと180度の8K 3D動画を楽しめる「Apple Immersive Video」に注目していて、業務でも技術検証を進めているところです。

現在、Appleのサイトで「visionOS2」のプレビューが公開されていて、更に進化した「Apple Immersive Video」の姿をイメージすることができます。「Apple Immersive Video」はコンテンツの体験や没入感が非常に高く、サイバーエージェントが提供する既存サービスや新規事業との親和性も高いので、技術検証を深める価値が十分にあると言えます。

その一方「Apple Immersive Video」のコンテンツ制作には、高性能な機材と複合的な制作ワークフローが必須で、技術的な投資やPDCAに費やす時間が必要なこともわかってきました。

例えば、視界の180度をカバーできる臨場感のある高画質録画や、空間オーディオを実現する良質な録音をするためには、高価な機材が必要です。2024年6月にブラックマジックデザイン社が「Apple Immersive Video」に対応した業務用カメラシステムと編集ソフトウェアを発表しましたが、その価格帯は1台数百万円と予想されます。撮影した高画質な動画の容量は1分あたり数ギガバイトを超え、その編集には高性能なグラフィックボードを搭載したPCが必要です。

「Apple Immersive Video」の没入体験や視聴体験を最大限活かすためには、開放感のある広いロケ地でしっかりとした撮影チームで収録し、丁寧に編集して仕上げたコンテンツが求められています。ビジネス的な案件となると、制作にも企業体力が求められることが想像されます。

私が働いている「極(きわみ)AIお台場スタジオ」でも、高価な機材やセットを随時充実させていますが、何よりそれら高性能な機材を使いこなす撮影メンバーやエンジニアの存在や、蓄積してきた知見やノウハウが必須となります。

Cyber AI ProductionsのチームやCAゼミ xRギルドのメンバーと一緒に、技術検証や制作事例を重ねていけたらと思っています。

── 「AR分野のNextExperts」として、今後はどんな役割を目指していきたいですか?

Developer Experts制度には様々な分野のExpertsがいます。私がAR分野のNextExpertsとして意識しているのが「目利きができるエンジニア」である事です。

私が担当するAR分野のような先鋭的な技術を、会社が事業として推進していく際、ともすれば不必要な設備投資や、将来的な技術的負債やセキュリティリスクになりかねないソフトウェア開発、短期的な採用の拡大やミスマッチなどに至るリスクもあります。

そんな時にAR分野のNextExpertsである自分が「目利きができるエンジニア」であることで、事業責任者や経営層に客観的な説明や、経営の判断材料を示すことができたらと考えています。

「目利きができるエンジニア」がいたとして、経営的に正しい意思決定に直結するとは限りませんが、少なくとも事業の成功確率の向上や費用対効果に見合った設備投資に役立てると思っています。

サイバーエージェントの強みの1つに、Developer Experts制度やCAゼミ制度などで、各分野で活躍するエンジニアが、部署やビジネスドメインをまたいで、積極的に技術検証やPoC開発を行っている技術カルチャーがあります。サイバーエージェントの「あした(未来)」に繋がる新規事業や課題解決の方法などを提案、決議する会議「あした会議」でも、Developer Expertsがチームに参加し、経営陣と議論を重ねながら、重要な経営判断をする場にいたりもします。

このようにDeveloper Experts制度に任命されたエンジニアは、技術で会社を牽引していく存在と言えます。例えば、私は2021-2022年にAR表現を使ったXRライブ配信を社内検証から進め横浜での大規模ライブ実施などを通じて、様々な実績を積んでいきました。

今では3Dキャラクターによるバーチャルライブで多くのファンが熱狂する時代です。サイバーエージェントのゲーム事業部でも、数々の素晴らしいタイトルがリリースされています。

ビジネス的な実装にはまだ遠いけど、コツコツと技術検証しているものが、数年後に大勢が熱狂するコンテンツになる可能性は十分にありえます。特に「visionOS」と「Apple Vision Pro」は「パソコンやスマホに代替するデバイス」と言われています。

私は、AR分野のNextExpertsとして、サイバーエージェントの「あした(未来)」を誰よりも先立って開拓し、道を切り開くエンジニアでありたいと考えています。

記事ランキング

-

1

サイバーエージェント2代目社長 山内隆裕のキャリアと人物像

サイバーエージェント2代目社長 山内隆裕のキャリアと人物像

サイバーエージェント2代目社長 山内隆裕のキャリアと人物像

-

2

Jリーグ百年構想リーグ開幕!世界で戦うビッグクラブへ

Jリーグ百年構想リーグ開幕!世界で戦うビッグクラブへ

Jリーグ百年構想リーグ開幕!世界で戦うビッグクラブへ

-

3

社長交代を重ねても持続的に成長する会社になるために 創業社長から2代目への社...

社長交代を重ねても持続的に成長する会社になるために 創業社長から2代目への社長交代

社長交代を重ねても持続的に成長する会社になるために 創業社長...

-

4

『スキャンダルイブ』ヒットの裏側 ー「作る」と「届ける」を分断させないAB...

『スキャンダルイブ』ヒットの裏側 ー「作る」と「届ける」を分断させないABEMAの勝ち筋

『スキャンダルイブ』ヒットの裏側 ー「作る」と「届ける」を...

【対談】ML/DSにおける問題設定術

~ 不確実な業界で生き抜くために ~

機械学習やデータサイエンスがビジネスの現場で当たり前になりつつある今、求められているのは、ビジネスの課題を実装に落とし込み、運用し、継続的な価値を生み出す視点となりつつあります。

サイバーエージェントでは、こうした実践的なスキルを持つ次世代のデータサイエンティストを育成すべく、2025年11月、新卒向け特別プログラム「DSOps研修2025」を実施しました。

「技術を社会実装する際の『問題設定』こそが重要である」 この研修のコンセプトに深く賛同いただき、特別講師としてお迎えしたのが、半熟仮想(株) 共同創業者であり、「Forbes JAPAN 30 UNDER 30 2022」にも選出された齋藤優太氏です。

第1部では、半熟仮想(株) 共同創業者であり、Forbes JAPAN「30 UNDER 30」に選出された齋藤優太氏をお招きし、「ML/DSにおける問題設定術」について講演いただきました。 続く第2部では、齋藤氏に加え、当社執行役員兼主席エンジニアの木村、AI Lab リサーチサイエンティストの暮石が登壇。「現場視点×経営視点」でパネルディスカッションを実施しました。

本記事では、白熱した第2部「パネルディスカッション」の模様をダイジェストでお届けします。